На мауле подняли тему падения трафика с Google, причем с классическим диагнозом- траф иссяк в октябре, то есть ровненько после прохождения очередной версии панды. В связи с чем появилось желание расписать некие аспекты, на которые следует обратить внимание, если на вашем сайте куда то пропал трафик с Google, или его количество сильно разнится с трафиком от Яндекс. Для затравки- приведу два простых примера собственных сайтов- одному все по барабану (кстати я так и не понял в чем дело, так как я на нем никаких работ по ограничению индекса не производил), ну а второй развлекательный портал который построен чуть более чем полностью на копипасте.

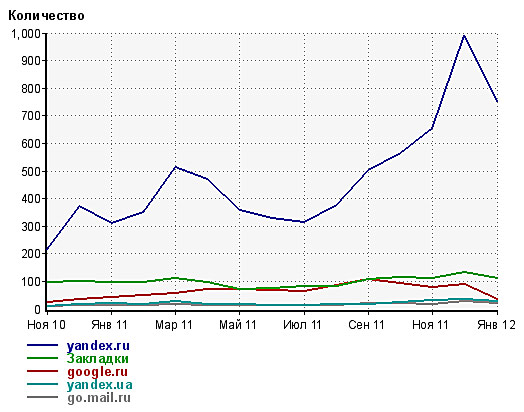

Развлекательный портал (Panda Detected, далее PD):

Всего страниц в Google 1,960

В основной выдаче Google 178

В supplemental выдаче Google 1782 (90.9%)

Всего страниц в Yandex 3217

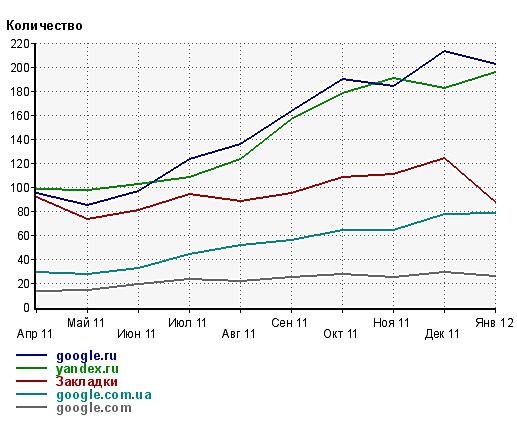

Второй сайт условно без перекосов с индексаций (далее БПИ):

Всего страниц в Google 1,520

В основной выдаче Google 419

В supplemental выдаче Google 1101 (72.4%)

Всего страниц в Yandex 915

Как мы видим на PD траф с Яндекса отличается от Google почти в десять раз, именно из-за того, что на сайте огромное количество дублей, помимо копипейста. БПИ конечно принадлежит к той тематике, которая ищется в своем большинстве профи, то есть в Google, но тем не менее, как видно из графиков- они идут вровень, тоже во многом благодаря тому что траф от Google просажен, хотя и не так сильно как у PD.

Собственно в данном ключе стоит обратиться внимание на сильные отличия в трафике с различных поисковых систем, большие различия в индексации поисковыми системами. После этого стоит проверить число страниц в supplemental index, в идеале это число должно стремиться к 0, как например бывает на толковых MFA, но до 20-30% не критично.

Для того чтобы проверить какие страницы сайта находятся в основном индексе выдачи Google следует в меню поиска ввести выражение site:yousite.com/& и вы увидите реальное количество страниц, участвующих в выдаче.

Также следует проверить склейку домена с www и без неё, ибо если она отсутствует, то для поисковых систем существует два идентичных сайта, дублирующих друг друга.

Теоретически в supplemental index отправляются не только дубли, но и не трастовые страницы, страницы с нулевым pr и прочий мусор, на взгляд Google, так что один из способов уменьшения этого количества- прогон статей сайта по профилям, покупка ссылок и статей на внутренние страницы, и повышение общего pr морды сайта для того чтобы его PR равномерно растекался по самому сайту, за счет перелинковки.

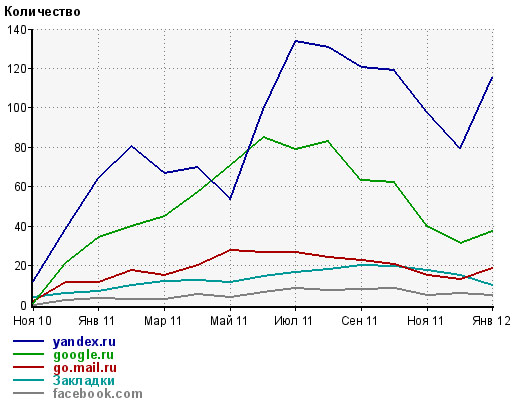

Вот например график посещалки еще одного довольно молодого сайта, который поймал в середине осени панду на свои 1500 страниц, и с которой я боролся в течении нескольких месяцев, пока наконец не перелопатил половину сайта, закрыв от индексации дубли, и постепенно уникализируя категории и теги, в связи с чем трафик несколько пошел вверх, хотя это может быть и выравниванием после новогоднего падения трафика.

Так что основная проблема падения трафика с Google- это как раз неправильная индексация сайта в поисковой системе, и, как следствие, наличие огромного груза, тянущего сайт вниз выдачи. Но пять же- дело такое- надо для себя решить для чего вы используете сайт- если для продажи ссылок, то вполне вероятно что вас не интересуют проблемы индексации, ибо ля этого дела, чем больше страниц находится в индексе поисковых систем тем лучше, тогда как если вы хотите зарабатывать на трафике, то решение проблем с индексацией- лучший путь в топы и к хорошему заработку.